在讨论Pig(一个用于处理和分析大数据的高阶语

- By imtoken下载官网

- 2025-08-28 20:37:08

引言

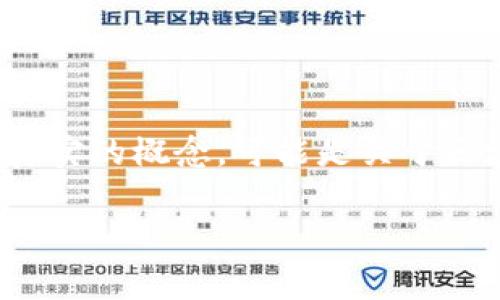

随着区块链技术的迅猛发展,Tokenim的概念逐渐进入人们的视野。Tokenim可能代表一种数字资产或代币,随着各种项目的推出,它在金融、供应链和其他行业中的应用也越来越广泛。然而,如何有效地处理与Tokenim相关的数据,特别是在大数据环境中,成为了业界亟需解决的问题。在这方面,Apache Pig为我们提供了强大的支持。

什么是Apache Pig?

Apache Pig是一个用于处理大规模数据集的高阶平台,建立在Hadoop之上。它允许用户以简化的语言编写数据流,称为Pig Latin,从而简化了数据处理流程。那么,你是否想过在各种区块链项目中处理和分析Tokenim交易数据时,Pig能为你带来哪些便利呢?

Pig的主要优势在于其友好的数据处理语法和高效的执行效率,它适合于非常复杂的数据分析任务,无论是结构化还是半结构化的数据。在当前快速发展的数字经济环境中,Tokenim的市场交易数据是海量的,如果手动处理这些数据,无疑是一个巨大的挑战,而Pig可以大大简化这一过程。

Tokenim的概念解析

在深入讨论如何利用Pig处理Tokenim的数据之前,我们需要清楚Tokenim的具体含义。Tokenim通常指的是与某种特定的区块链平台相关联的代币,这些代币可以在特定的网络上使用,进行交易、投资或者作为使用某种服务的凭证。举个例子,在去中心化金融(DeFi)平台上,用户可以使用Tokenim进行借贷、交易或者质押。

在这个背景下,Tokenim的数据分析尤为重要。通过分析Tokenim的交易记录、用户行为以及市场趋势,企业和开发者可以获得宝贵的市场洞察,从而做出更明智的决策。

如何利用Pig处理Tokenim数据

针对Tokenim的庞大数据集,我们可以利用Pig来进行一系列数据分析流程,包括数据清洗、转化和分析等。具体而言,我们可以按照以下步骤来进行:

1. 数据加载

首先,利用Pig将Tokenim的数据从多个来源(如区块链节点、交易所API、数据仓库等)加载到Hadoop环境中。这一过程可以通过Pig的LOAD命令轻松实现。

2. 数据清洗

在获取数据后,通常需要进行清洗,以确保数据的准确性和完整性。通过Pig的FILTER和DISTINCT等操作,可以剔除重复数据或无关数据,以获得更加干净的数据集。这你是否觉得是处理数据的基础步骤呢?

3. 数据变换

数据清洗完成后,我们可能需要对数据进行变换,以便于后续的分析。例如,将交易时间戳转化为可读的时间格式,或者将交易金额转换为相同的币种,这些操作都可以通过Pig的FOREACH和GENERATE操作来实现。

4. 数据分析

数据预处理完成后,利用Pig分析Tokenim的市场趋势,例如统计各类Tokenim的交易频次、交易量等指标,这可以通过GROUP和COUNT等操作来实现。这一阶段,我们可以进行更加深度的数据挖掘,通过统计模型等方法,发现潜在规律和趋势。

Pig在Tokenim分析中的应用案例

接下来,我们可以看看具体的应用案例,以便更好地理解如何利用Pig进行Tokenim数据分析。

-- 加载Tokenim交易记录数据

transactions = LOAD 'hdfs://path/to/tokenim_data.csv' USING PigStorage(',') AS (timestamp:chararray, user_id:chararray, token_amount:double, token_type:chararray);

-- 数据清洗:过滤掉金额为零的交易

cleaned_data = FILTER transactions BY token_amount > 0;

-- 统计各类Tokenim的交易总量

total_per_token = FOREACH (GROUP cleaned_data BY token_type) GENERATE group AS token_type, SUM(cleaned_data.token_amount) AS total_amount;

-- 将结果存储到HDFS

STORE total_per_token INTO 'hdfs://path/to/total_per_token' USING PigStorage(',');

通过这个简单的代码示例,我们可以看到如何利用Pig完成数据加载、清洗、变换和分析的过程。这是否让你对Pig的应用有了更深的认识呢?

总结

在大数据时代,区块链和数字货币的快速发展导致出现了大量Tokenim等数据。有效处理这些数据,成为分析市场、制定策略的重要能力。在这方面,Apache Pig作为一种高效的工具,可以显著提升用户对于Tokenim相关数据的处理能力。通过本文的探讨,希望能够引发更多的思考和讨论。

你是否还在为如何处理如此海量的数据而感到困惑?或者你是否发现了利用Pig来进行数据分析的乐趣与价值?无论如何,只要你愿意探索,数据的世界将会为你打开更多的可能性和机会。